像AlphoGo一样应用强化学习进行游戏对战( 三 )

这种方法的最大缺点是代理丢失了信息——它必须使所有的与游戏的实际玩家不同 , 在它们中的任何一个发挥作用之前 。 虽然我们人类玩家倾向于在每个回合开始时制定计划 , 但拙劣的射击或冲锋会导致计划发生变化 。 这可能发生得非常突然 , 如果可能的话 , 我不想妨碍AI这样做 。 有了BigActions , AI无法利用我们都喜欢的Warhammer的动态来回特性 。 它还阻止了AI玩完整的游戏——乱序动作是规则的一部分 。

【像AlphoGo一样应用强化学习进行游戏对战】3.每模型或每单元动作

相关经验推荐

- 骷髅:这个有点意思英雄联盟刚出来的时候|英雄联盟:当初的英雄模型,努努和放出来的一样,大龙:好丑啊!

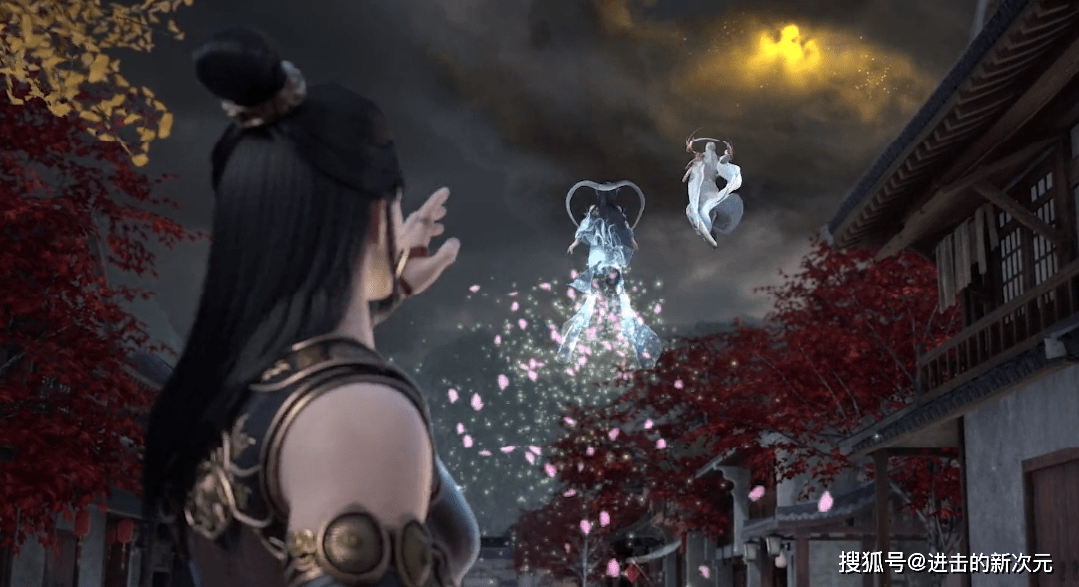

- 一梦江湖:金陵奇妙会重磅来袭!江湖人的年会,就是不一样

- DNF里面能有几把剑像“它们”一样受到剑神的青睐?

- 欧成不忘老对手:LCK的新生代AD让我想起乌兹,像是能改变ADC位置

- 鲨鱼哟发现失散多年的妹妹?网友戏称其为海豚妹,鲨鱼都直言很像

- LCK上单卧龙凤雏竟全在DK?换上Burdol一样看着队友四打五

- P1S《变形金刚:赛博坦之战》威震天雕像终极版售价1849美元

- 瑞文的光速QA太难?来《英雄联盟手游》体验不一样的光速QA

- 冠军AD都这么帅的吗?阿水的少年感,Viper的秀气,LWX像厄斐琉斯

- 阴阳师SP山兔主题活动详情公开不通过小程序一样能解锁入手