文章插图

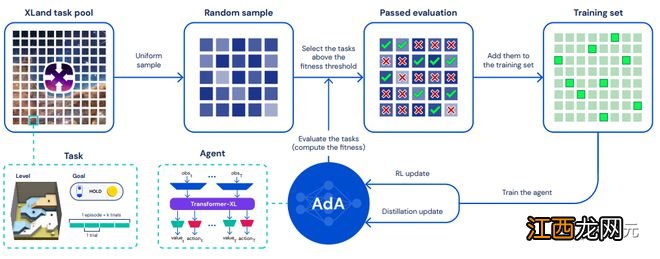

该训练方法结合了三个关键部分:1)指导智能体学习的课程(curriculum);2)基于模型的RL算法来训练具有大规模注意力记忆的代理;以及,3)蒸馏以实现扩展 。

1. 开放端任务空间:XLand 2.0

XLand 2.0相比XLand 1.0扩展了生产规则的系统,其中每条规则都表达了一个额外的环境动态,从而具有更丰富、更多样化的不同过渡功能 。

XLand 2.0是一个巨大的、平滑的、多样化的适应问题的任务空间,不同的任务有不同的适应性要求,如实验、工具用法或分工等 。

例如 , 在一个需要实验的任务中,玩家可能需要识别哪些物体可以有用地结合,避免死胡同,然后优化他们结合物体的方式,就像一个玩具版的实验化学 。

文章插图

每个任务可以进行一次或多次试验,试验之间的环境会被重置,但智能体记忆不会被重置 。

上图中突出显示的是两个示例任务,即「Wrong Pair Disappears」和「Pass Over Wall Repeatedly」,展示了目标、初始物体、生产规则以及智能体需要如何与它们互动以解决任务 。

2. 元强化学习

根据黑箱元RL问题的设置,研究人员将任务空间定义为一组部分可观察的马尔科夫决策过程(POMDPs) 。

对于一个给定的任务,试验的定义为从初始状态到终端状态的任意转换序列 。

在XLand中,当且仅当某个时间段∈[10s, 40s]已经过去时 , 任务才会终止,每个任务都有具体规定 。环境以每秒30帧的速度变化 , 智能体每4帧观察一次 , 因此任务长度以时间为单位,范围为[75, 300] 。

一个episode由一个给定任务的试验序列组成 。在试验边界,任务被重置到一个初始状态 。

在领域内 , 初始状态是确定的,除了智能体的旋转,它是统一随机抽样的 。

在黑箱元RL训练中,智能体利用与广泛分布的任务互动的经验来更新其神经网络的参数,该网络在给定的状态观察中智能体的行动政策分布提供参数 。

如果一个智能体拥有动态的内部状态(记忆),那么元RL训练通过利用重复试验的结构,赋予该记忆以隐性的在线学习算法 。

在测试时 , 这种在线学习算法使智能体能够适应其策略,而无需进一步更新神经网络权重 , 也就是说,智能体的记忆不是在试验边界被重置,而是在episode边界被重置 。

3. 自动课程学习(Auto-curriculum learning)

鉴于预采样任务池的广度和多样性,智能体很难用均匀采样进行有效地学习:大多数随机采样的任务可能会太难(或太容易),无法对智能体的学习进度有所帮助 。

相反,研究人员使用自动化的方法在智能体能力的前沿选择相对「有趣 」(interesting)的任务,类似于人类认知发展中的「近侧发展区间」(zone of proximal development) 。

具体方法为对现有技术中的no-op filtering和prioritised level replay(PLR)进行扩展,能够极大提升智能体的性能和采样效率,最终成为了一个新兴的课程,能够随着时间的推移选择越来越复杂的任务 。

4. RL智能体

学习算法

RL算法选择Mueslie,输入为一个历史相关的编码(history-dependent encoding),输出为RNN或Transformer,AdA学习一个序列模型(LSTM)对后续多步预测价值、行动分布和奖励 。

文章插图

记忆架构

在每个时间步,将像素观察、目标、手、试验和时间信息、生成规则、之前的行动和奖励嵌入化并合并为一个向量 。

相关经验推荐

- 怎样教孩子学习绘画 如何教孩子学习绘画

- 怎么能让孩子主动学习

- 一轮复习地理学习重点 有哪些重点地理知识点

- 《仙乐传说加强版》游戏强化功能和画面参数公布

- 松乳菇的种植技术在哪里可以学习

- 对话华创资本合伙人熊伟铭:冰封重启,2023年投资市场 “有风景也有迷雾”

- 孩子怎样才能学习好

- 学习书法的好处有哪些?,学书法的好处是什么?

- 怎么学习温室工程

- 古人也有食物造假吗,古代怎么监管食品安全