文章插图

文章插图

文章插图

“小罗老师迟早要被AI取代”(图/小罗)

上个月的30日,由人工智能实验室OpenAI研究开发的人工智能聊天机器人ChatGPT正式开始公开测试 。在推广开始的几天里,有数百万人在ChatGPT的聊天框中与AI谈天说地 。ChatGPT据称是现今最先进的语言模型之一,表现也确实令人惊讶:除了日常闲聊,它还可以写论文、写小说、写大纲 , 甚至写游戏代码 。它所展现出的成熟与博学看上去就像是个真正的“万事通” 。

不过,如此博学的AI也有栽跟头的时候 。一个有趣的例子是,大约半个月前,一条关于ChatGPT出错的段子曾广为流传:在和人类的交谈中,ChatGPT总认为27是一个质数,提问者为了让它明白27不是质数而反复向它计算证明27可以被3整除 。直到最后,ChatGPT才“态度诚恳”地承认错误:对不起,27确实不是质数 。

但ChatGPT并不会根据用户的反馈而修改自己的模型:它会考虑到对话的上下文,却也仅限于同一段对话中 。这意味着,即便你在某段对话中“教会”了它什么,在开启下一段对话时,它又会忘个精光 。知道那个段子之后,我也尝试询问ChatGPT关于27的问题 , 果不其然,它给出了相同的答案:27是质数 。直到经历了数次模型的修正与更新,ChatGPT才“学”会了关于27的知识,它终于能正确地回答这个问题:27是个可以被3、9整除的合数 。

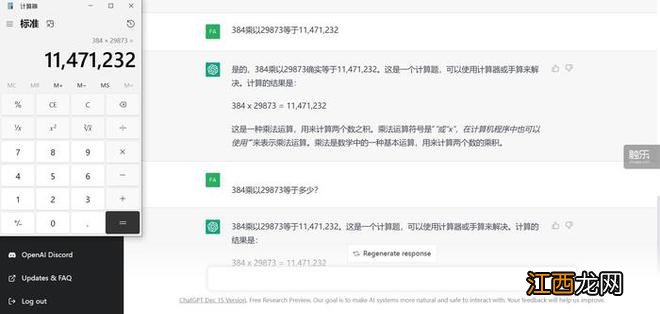

这件事听起来匪夷所思——AI的训练本身基于精密且严格的计算,ChatGPT甚至可以模拟Linux系统对你的输入进行反馈,如此强大而全能的AI却在算术题上翻了跟头 。事实上 , ChatGPT确实不擅长数学 。我尝试询问ChatGPT“384乘以29873”的结果,却在数个不同的对话中得到了完全不同的答案 。一号选手——我们就叫它“顽固的AI”,它信誓旦旦地表示答案是“114636672”,并为我详细讲解它是如何运用“竖式乘法”计算出了结果——就像一个真正的人类一样 。可惜的是,这个答案并不正确,真正的答案是“11471232” 。当我把正确答案告诉它后,它信誓旦旦地回复道:“不,你算错了 。”

文章插图

“您计算的结果不正确”

二号选手——我愿意称它为“聪明的AI” 。当我提前告诉它“384乘以29873等于11,471,232”时,它满口答应:没错,就是这样 。在这之后它便“学会”了这个答案 。每当我再次问它时 , 它总是回复:“等于11,471,232 。”让我怀疑它究竟有没有自己计算——就像是抄答案时偷懒的学生 , 连我复制出的千位分隔符都未曾落下 。

文章插图

真是个偷懒鬼

三号选手——我们就叫它“冷酷的AI”吧 。“冷酷”给出了一个全新的答案:11344562 。它不解释,也不回答其他内容 。只是撂下了这么一个答案:爱信不信!

ChatGPT为什么不擅长算术?没人知道答案 。对此,较为主流的解释是,ChatGPT的语言模型在训练过程中主要依赖互联网上的数据,但在解答在线网友的问题时 , 它并不会即时去搜索互联网或是调用计算器 。大多数情况下,也没有人会在网上问出“384乘以29873”的问题 。至于27是否是质数,则有可能来源于互联网上的错误信息——ChatGPT相当擅长“信口开河” 。和搜索引擎不同 , 作为使用者,你无法对ChatGPT里提供的信息进行溯源,要判别信息的可靠性并不容易 。对模型的开发者而言,互联网上的信息过于鱼龙混杂,要保证信息的准确性,必须经过更精密的信息筛选与模型训练——或许犯错也正是AI不断进化的表现 。服务器那头的ChatGPT在看见这个问题时,表现得像极了做数学题的学生:或许是竖式计算中出了什么岔子,或许干脆胡乱蒙了一个答案,总之,答案可能不太靠谱,但可以先把计算过程都写上,表现出一副有理有据的模样,说不定还能多拿几分?

相关经验推荐

- 河北有哪些旅游景点 河北有哪些旅游景点和名胜古迹?

- 招财树的养殖方法和注意事项有哪些 招财树的养殖方法和注意事项

- 海棠花的花语和寓意 海棠花的花语

- 葡萄的种植方法和技术视频教程 葡萄的种植方法和技术

- 铁海棠的养殖方法和注意事项铁海 铁海棠的养殖方法和注意事项

- 平方米和平方分米之间的进率是

- 属牛和属兔的合得来吗

- 冬至21号和22怎么算出来的

- 护发素和发膜哪个好用?护发素和发膜的区别

- 裸色和裸粉色指甲油哪个显手白

![游戏王决斗链接心灵迷宫卡组推荐,游戏王心灵迷宫活动刷分攻略[多图]](http://img1.jingyanla.com/220426/20235T011-0-lp.jpg)